photonは、WEBサイトの情報収集ツールです。kali linux2025.2からの新ツールです。

photonとは「光子」のことなので、普通にgoogleで検索するとあれこれ関係ないものが沢山引っ掛かります。このツールを検索する時は ” photon OSINT ” などで検索すれば良いかと。(検索結果は英語ばかりですが)

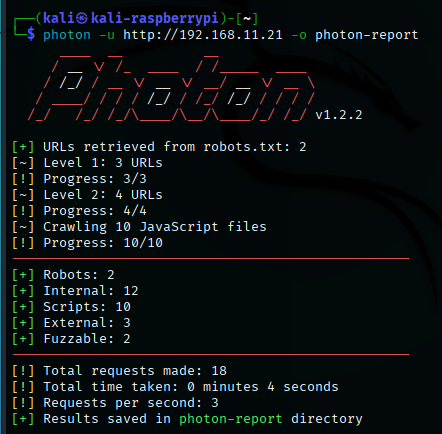

今回は、例によってラズパイ5(左)から、ラズパイ4B(右)のサイトを探索します。

高速に多数のリクエストを送るため、ターゲットサイトには負荷がかかります。他人の管理下のサイトを許可なく探索するのは迷惑行為になるのでやめましょう。

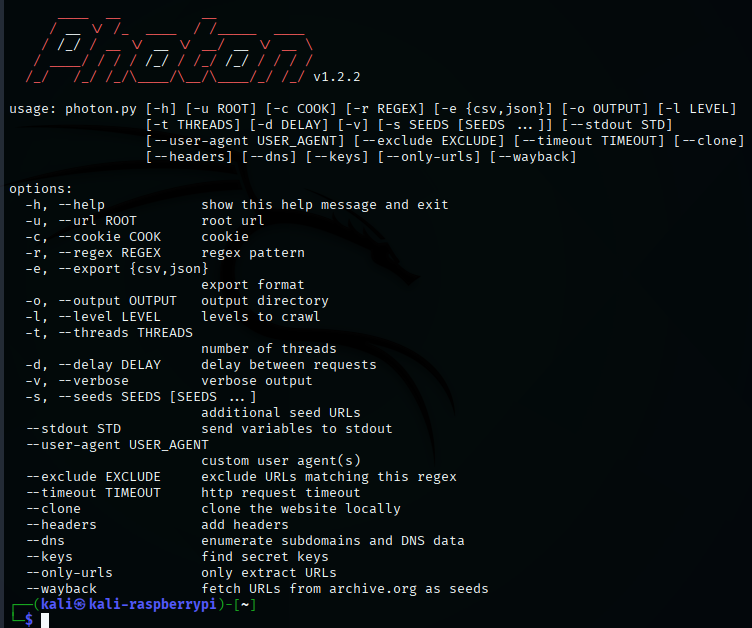

ヘルプ画面

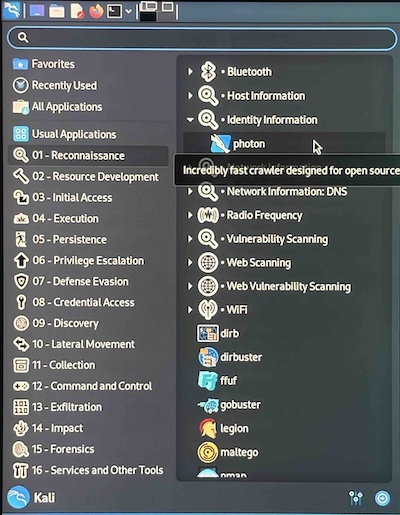

kali ー 01-Reconnaissance ー Identity Information ー photon

1つのツールで1つの分類

ターミナルでヘルプ画面が開きます。

実行

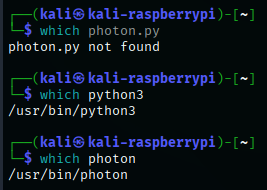

helpでは、” photon.py ” となっていますが、普通に ” photon ” で実行できます。( ” photon.py ” では登録がないので逆に実行できない)

以下の構文で実行します。

photon -u <ターゲットサイトのURL> -o <結果の出力先ディレクトリ>

実行結果の統計が表示されます。(ターゲットサイトが、内容のない空のサイトなので、実行時間も短く収穫も少ないです)

実行結果の解釈

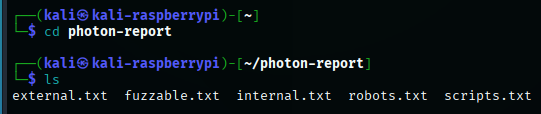

結果の出力先ディレクトリに、結果が書き込まれています。

今回の成果は以下の5ファイル

- external.txt

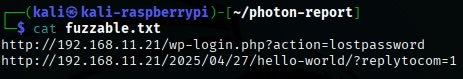

- fuzzable.txt

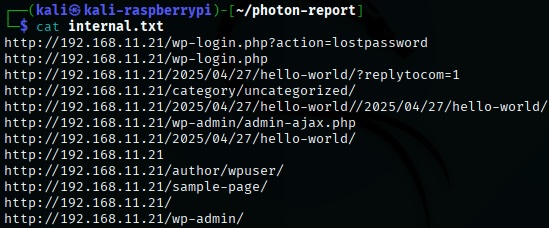

- internal.txt

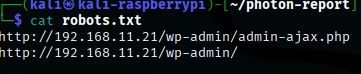

- robots.txt

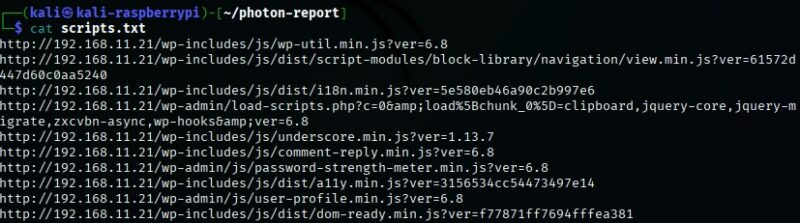

- scripts.txt

内容は以下の通りです。

主なオプション

- -u <url> :ターゲットURLの設定

- -o <directory> :出力ディレクトリの指定

- -l <数字> :探索する階層(デフォルトは2)

- –dns :サブドメインも探索

- –keys :APIキーを検出

- –only-urls :URLのみ収集

- –wayback :Wayback Machineを使用して過去のURLを収集

- –exclude :特定のキーワードが含まれるURLを除外

- –timeout <秒数> :接続が長くなる場合にタイムアウトする

結果の解釈

今回得られた結果

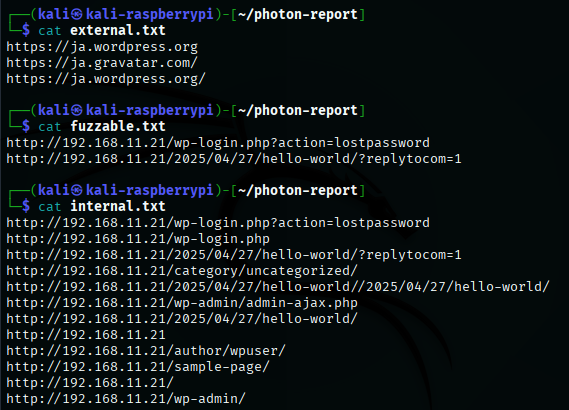

external.txt

外部リンクをまとめたファイルです。

外部依存分析、データの外部送信チェックに使用します。

fuzzable.txt

” fuzz ” 出来るURL(パラメータの変更により変動するURL = 攻撃対象になりやすいURL)を集めたファイルです。

裏返せば脆弱性が存在するポイントでもあります。

URLの構造について

URL文字列中の “ ? ” がクエリ文字列の始まりを宣言する記号です。

ttps://example.com/path?key1=value1&key2=value2&key3=value3…..

クエリ文字列は、&で区切られたパラメータの集合体です(パラメータが1つだけの時は&は無い)

key1=value1&key2=value2&key3=value3…..

1つのパラメータは、 ” キー ” と ” 値 ” がセットとなっており、 ” = ” で繋がれています。

このパラメータがサーバーに渡されます。

key=value

で、このvalueの部分に脆弱性が潜んでいる可能性があるわけです。

よってこの部分を他ツールなどで攻撃検査します。(つまりここが攻撃ポイント)

internal.txt

内部リンクをまとめたファイルです。

構造解析、ディレクトリ探索、脆弱性調査に使用します。

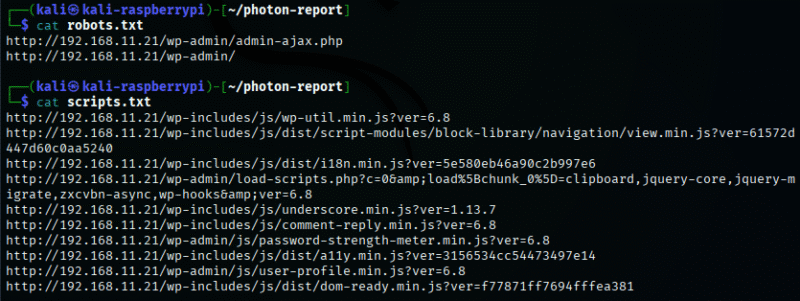

robots.txt

サイトが指定しているrobots.txtの内容(クロール禁止ページの情報)を示します。

検索エンジンには見せないページの発見に役立ちます。

scripts.txt

ウェブページ上で読み込まれている JavaScript ファイルの URL 一覧を収めたファイルです。

参考1)スクリプトの自動解析ツール: ” LinkFinder ” , ” SecretFinder ” , ” JSParser “

参考2)特に注目すべき文字列: ” apikey ” , ” token ” , ” auth ” , ” secret ” , ” key ” , ” admin “

参考3)JavaScriptは難読化・縮小化(minify)されていることが多いので、その場合は beautify(整形)して読むと解析しやすくなります。そのためのツール(オンラインツール: https://beautifier.io/ 、CLIツール: js-beautify(Python用))

その他の結果

今回は得られませんでしたが、以下のファイルが得られる場合が有ります。

| ファイル | 意味・用途 |

|---|---|

| emails.txt | クローリング中に見つかったメールアドレスの一覧/ソーシャルエンジニアリングの起点、連絡先調査など |

| files.txt | PDF, DOC, XLS などの重要そうなファイルのURL/情報漏洩の痕跡確認、内部資料の発見など |

| intel.txt | Photonが検出した「インテリジェンス系のデータ」 |

| jsfiles.txt | JavaScriptファイルのURL/JSにハードコードされたAPIキー、サーバー名、エンドポイント等の発見・フロントエンドの構成分析 |

| keys.txt | 見つかったAPIキー、認証トークン、機密っぽい文字列/セキュリティインシデントの兆候発見 |

| links.txt | クローリング中にたどった全リンク(内部/外部含む)/リンク構造の分析、サブページの確認など |

| urls.txt | クローリングで実際にアクセスしたすべてのURL(簡易版)/アクセスログの再現、サーバー挙動の検証(links.txtより少し絞られた情報になります。) |

wayback-urls.txt ( –wayback オプション) | Wayback Machineから得られた過去のURL/すでに削除されたページの存在確認 |

まとめ

photonはWEBサイトの(脆弱性を含めて)解析するツールです。

解析先のサイトが空サイトなので、意味のある情報は殆ど引っ掛かりませんでしたが、個人的にはWebサイトの構造の勉強にはなりました。

コメント